js获取json数据太长就无法获取: 如何处理长JSON数据的获取和解析问题

在现代Web开发中,JavaScript被广泛用于获取和解析JSON数据。当获取的JSON数据过长时,可能会遇到一些问题,比如浏览器的限制、性能瓶颈或是内存不足等。本文将深入探讨如何有效地获取和处理长JSON数据,并提供一些优化建议。

理解JSON数据的结构和长度问题

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,其结构清晰且易于人类阅读。JSON数据通常用于服务器与客户端之间的通信。当数据量很大时,可能会引发诸如解析失败、加载时间过长等问题。

如果获取的JSON数据过长,可能会导致浏览器在解析时消耗大量的内存资源,甚至导致应用程序崩溃。很多浏览器在处理网络请求时会有一定的限制,过大的数据包可能无法完整获取。因此,在处理大数据量时,我们需要考虑如何避免这些潜在的问题。

分段请求与懒加载技术

一种有效的解决策略是通过分段请求(Pagination)和懒加载(Lazy Loading)来分批获取JSON数据。这种方法可以显著减少每次请求的数据量,从而降低内存消耗和提高加载速度。

分段请求通常涉及到后端的API设计,开发者可以设置每个请求返回一定数量的记录。前端JavaScript代码则负责在用户滚动到页面底部或点击加载更多按钮时,再次发起请求,以获取下一批数据。这种方法不仅能够提高用户体验,还能有效减少服务器的负担。

懒加载技术可以很好地应用于长列表或无限滚动的场景。只加载用户当前可见部分的数据,等用户向下滚动时再异步请求后续数据。这可以通过Intersection Observer API来实现,减少不必要的DOM渲染与资源消耗。

压缩与优化JSON数据

如果长JSON数据的确是必需的,可以通过压缩与优化来减少数据传输量。服务器端可以对数据进行压缩,使用Gzip或Brotli等压缩算法,在传输过程中显著减小数据体积。

开发者还可以进行数据优化,在返回JSON数据之前去除无用的信息,仅保留客户端需要的数据字段。这种方式不仅提升了传输效率,还能减少前端解析的复杂性。,可以仅返回需要的用户ID和名称,而不返回所有详细信息。

使用合适的工具和库

在JavaScript中,有许多工具和库可以帮助更好地处理长JSON数据。,可以使用`fetch` API进行网络请求,并利用`async/await`语法实现代码的清晰可读。对于解析较大的JSON数据,可以考虑使用流式解析库,如`JSONStream`,来处理数据的逐块解析,避免一次性将全部数据加载到内存中。

同时,开发者可以使用浏览器的开发者工具来监视网络请求,确保获取的数据量在合理范围内,并及时优化请求。这可以帮助及时发现问题,并通过分析网络通讯情况来进一步改进数据获取策略。

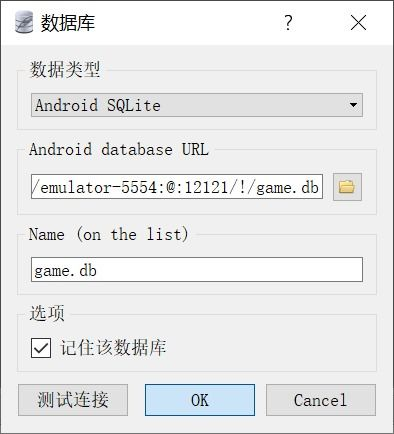

缓存策略与持久化存储

在获取长JSON数据时,合适的缓存策略也十分重要。适当的缓存可以避免重复请求相同的数据,从而提升效率。可以使用浏览器本地存储(localStorage或sessionStorage)来持久化缓存数据,减少用户的网络请求频率。

,当用户首次加载数据时,可以将获取到的JSON数据保存在localStorage中。下次用户访问页面时,检查缓存中是否已有相关数据,从而选择直接使用本地存储的数据,显著提高页面加载速度。

如果你的应用使用Service Worker技术,可以实现更复杂的缓存机制,将网络请求和缓存策略结合起来,离线使用时也能保持数据的有效性和一致性。

获取长JSON数据可能会引起许多问题,但通过分段请求、压缩与优化数据、使用适合的工具和库、以及合理的缓存策略,我们可以有效地解决这些问题。掌握这些技巧,不仅能够提升应用的性能,还能改善用户的体验。随着Web技术的发展,了解并应用这些策略无疑将让开发者在大数据处理上游刃有余。