js获取json数据太长就无法获取怎么办

理解JSON数据的限制

在JavaScript中处理JSON数据时,开发者有时会遇到数据长度问题。当JSON数据过于庞大时,可能导致浏览器或JavaScript引擎在解析数据时效率低下,甚至出现错误。这种情况常见于大规模的API响应或数据文件。了解这些限制,有助于我们找到合适的解决方案,以便有效地处理长JSON数据。

分块处理大数据

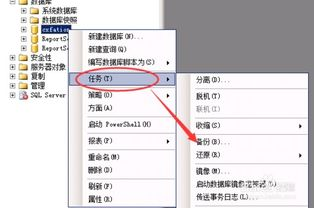

一种常见的处理长JSON数据的方法是将其分块处理。即便是非常长的JSON数组或对象,也可以通过对数据进行分页或分块来解决解析效率的问题。,你可以将数据按页分开,先请求第一部分的数据,进行处理,再请求下一部分的内容。这不但降低了单次数据传输的数量,也能提升用户体验。通常,在API中,你可以在请求时添加分页参数,如`page`和`limit`,从而只获取所需的数据。

使用流式处理技术

另一个处理长JSON数据的有效方法是使用流式处理技术。这种技术允许你在数据到达时立即处理部分数据,而无需等待整个数据集加载完成。Node.js提供了很多优秀的流处理库,可以帮助你逐块解析JSON数据,以减少内存使用和提高性能。,使用`JSONStream`库,你可以逐行读取和解析JSON对象,从而有效地处理大型JSON数据:

const fs = require('fs');

const JSONStream = require('JSONStream');

fs.createReadStream('largeData.json')

.pipe(JSONStream.parse('*'))

.on('data', function(data) {

console.log('Parsed data:', data);

})

.on('end', function() {

console.log('Done processing file.');

});

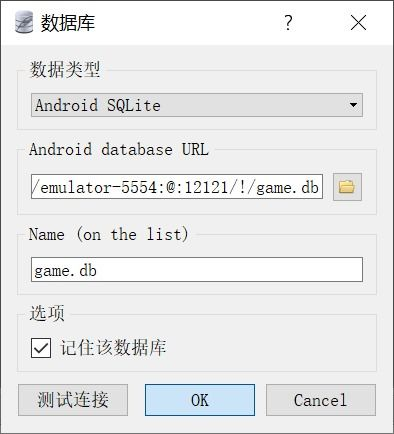

压缩和优化JSON数据

你还可以通过压缩和优化JSON数据来解决载入过大的问题。JSON数据往往包含许多重复和冗余的信息,这增加了数据的长度。通过压缩工具(Gzip)和优化工具,可以显著减少JSON数据的体积。在服务器端生成JSON响应时,压缩数据以减少传输大小,可以帮助快速响应请求。大多数现代浏览器和服务器都内置了对Gzip压缩的支持,因此可以轻松实现。

本地存储与缓存策略

为了提高性能并缓解长JSON数据的处理压力,你还可以采用本地存储和缓存策略。通过将JSON数据缓存到浏览器的`localStorage`中,可以在后续的请求中快速访问这些数据,而不必重新加载。对于经常请求的数据,设置合理的缓存策略,可以显著减少对服务器的请求,提高应用程序的响应速度。:

const cachedData = localStorage.getItem('myData');

if (cachedData) {

const data = JSON.parse(cachedData);

console.log('Loaded from local storage:', data);

} else {

fetch('api/data')

.then(response => response.json())

.then(data => {

localStorage.setItem('myData', JSON.stringify(data));

console.log('Fetched and cached data:', data);

});

}

选择合适的数据格式

如果JSON数据过长且复杂,可能需要考虑选择合适的数据格式。根据项目的需求,可能可以使用其他数据格式,如Protocol Buffers或MessagePack等。这些替代格式提供了比JSON更高效的数据序列化和反序列化方法,尽管可能会增加复杂性,但能更有效地处理大数据集。在某些情况下,通过选择更高效的数据格式,可以显著提升性能和用户体验。

在处理过长的JSON数据时,可以采用多种策略,包括分块处理、流式处理、数据压缩与优化、本地存储和合适的数据格式选择。通过这些方法,开发者不仅能有效地降低内存负担,还能提升数据解析效率,从而改善应用程序的性能和用户体验。时刻关注使用数据的方式,并根据项目需求做出灵活的调整,才能在复杂数据环境中稳定运行。