HTML代码如何获取: 学习有效的方法和技巧

在现代网页开发中,获取和理解HTML代码是每个开发者的基础技能。在这篇文章中,我们将深入探讨几种获取HTML代码的方法,包括使用浏览器的开发者工具、手动查看网页源代码以及程序化抓取数据等技巧。无论您是一名初学者还是有经验的开发者,这些内容都将对您有所帮助。

使用浏览器的开发者工具获取HTML代码

大多数现代浏览器,Google Chrome、Mozilla Firefox和Microsoft Edge,都内置了强大的开发者工具,这些工具使我们能够轻松获取网页的HTML代码。

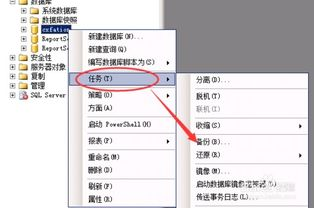

要使用这些工具,打开您想要获取HTML代码的网页。接下来,右键点击页面上的任意位置,并从上下文菜单中选择“检查”或“检查元素”。这将打开开发者工具界面,在这里您可以看到网页的结构化HTML代码。

在开发者工具面板中,您可以看到一个“元素”选项卡,显示了当前网页的DOM树。在此处,您可以浏览各个HTML元素,并查看他们的属性和内容。如果您需要复制某个特定元素的HTML代码,只需右键单击该元素,选择“复制”选择“复制元素”或“复制外部HTML”。这对于需要提取特定信息的任务非常有用。

查看网页源代码

除了使用开发者工具外,您还可以直接查看网页的源代码。这种方法对所有类型的浏览器都适用。只需在浏览器中打开网页,右键单击页面并选择“查看页面源代码”或使用快捷键“Ctrl+U”。

查看源代码后,您将看到该网页的完整HTML结构,包括所有的标记、脚本和样式。可以使用“Ctrl+F”快捷键在页面源代码中搜索特定的关键词,以快速定位所需的信息。不过,要注意的是,有些动态生成的内容可能不会直接出现在源代码中,而是通过JavaScript在页面加载后添加的。

程序化获取HTML代码(网页抓取)

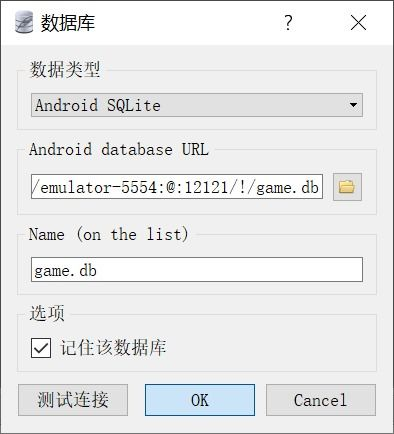

对于需要在多个页面上提取相似数据的应用场景,程序化获取HTML代码变得十分重要。使用各种编程语言和库(如Python的Beautiful Soup或Scrapy),您可以轻松编写脚本以自动抓取网页内容。

以Python为例,您可以使用requests库获取网页内容,使用Beautiful Soup解析HTML代码。以下是一个简单的抓取示例:

import requests

from bs4 import BeautifulSoup

# 请求网页

url = 'https://example.com'

response = requests.get(url)

# 解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 获取特定数据

for item in soup.find_all('div', class_='example-class'):

print(item.text)

这个脚本将抓取指定网页并打印出所有具有类名“example-class”的div元素的文本内容。通过这种方式,您可以高效地收集大量数据,进行分析和处理。

注意事项与最佳实践

在获取HTML代码时,有几个关键的注意事项和最佳实践是必须遵守的。确保您了解并遵循网站的robots.txt文件以及其使用条款,以确保您的抓取行为是合法的。过于频繁的请求可能会导致IP被封锁,因此在抓取时请设置合理的延迟。

对于动态内容,您可能需要模拟浏览器行为。某些网站使用JavaScript加载内容,您可以使用selenium库来控制无头浏览器执行这些操作,抓取数据时更加灵活。

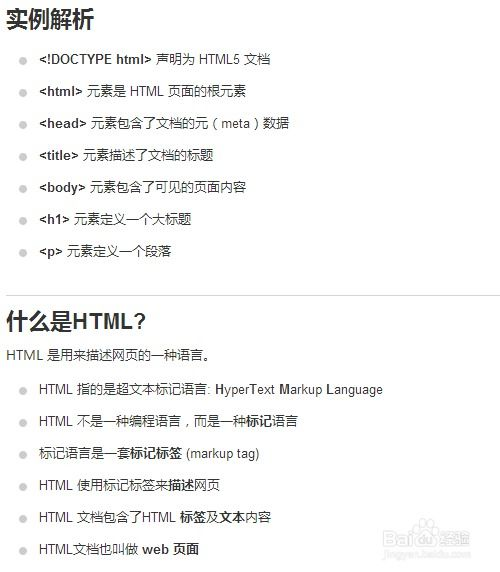

对于数据结构的解析,建议您详细了解HTML和CSS选择器的用法,这将大大提高您获取和处理数据的效率。

通过掌握以上技巧,您将能够有效获取HTML代码,并利用这些信息构建自己的应用或进行数据分析。学习和实践这些技能将使您在网页开发和数据抓取领域走得更远。