Python爬虫框架有哪些:深入理解不同的爬虫工具

简介:Python爬虫框架概览

在当今信息爆炸的时代,数据的获取和处理变得尤为重要。Python作为一门功能强大且易于学习的编程语言,在爬虫开发领域尤为突出。Python社区提供了多种爬虫框架,这些框架能够帮助开发者快速构建高效的爬虫程序。本文将详细介绍一些流行的Python爬虫框架,以及它们的特点和使用场景。

Scrapy:功能强大的爬虫框架

Scrapy是一个快速的、高层次的web爬虫框架,用于抓取web站点并从页面中提取结构化的数据。Scrapy使用了Twisted异步网络库,支持异步处理,能够显著提高爬虫的运行效率。Scrapy提供了丰富的中间件和扩展,可以方便地进行定制化开发。Scrapy还内置了多种爬虫策略,如下载延迟、重试机制等,以适应不同的爬取需求。

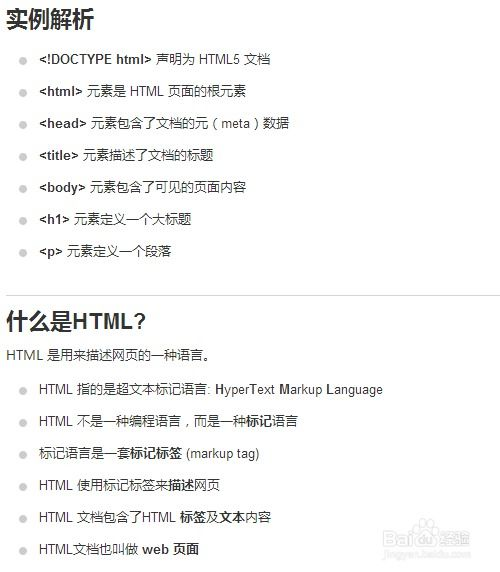

BeautifulSoup:简洁的HTML解析库

BeautifulSoup是一个用于解析HTML和XML文档的Python库。它能够将复杂的HTML文档转换成易于使用的数据结构,使用这些数据结构来提取所需的信息。BeautifulSoup与Python标准库中的urllib和lxml等库配合使用,可以方便地进行网页的请求和解析。虽然BeautifulSoup本身不是一个完整的爬虫框架,但它在很多简单的爬虫项目中被广泛使用。

Selenium:浏览器自动化测试工具

Selenium是一个用于自动化web应用程序测试的工具,它支持多种浏览器和编程语言。Selenium可以模拟用户的真实操作,如点击、输入、滚动等,因此非常适合处理需要交互的动态网页。使用Selenium,开发者可以编写脚本来控制浏览器,获取网页的实时内容。虽然Selenium在处理速度上可能不如其他爬虫框架,但它在处理JavaScript渲染的页面方面具有独特优势。

Mechanize:Python的网页自动化库

Mechanize是一个Python库,用于模拟浏览器行为,它提供了一个简单的API来处理HTTP请求和响应。Mechanize支持自动处理cookies、会话和重定向,使得开发者可以专注于数据的提取和处理。Mechanize同样适用于处理动态网页,但它的性能通常优于Selenium,因为它使用了Python的urllib库来处理HTTP请求。

PyQuery:类似jQuery的库

PyQuery是一个使Python操作HTML文档变得简单的库,它类似于jQuery,提供了一种简洁的方式来选择、过滤和操作HTML元素。PyQuery可以与lxml或BeautifulSoup等解析器配合使用,以提供更强大的HTML解析能力。PyQuery特别适合于快速开发和原型设计,因为它的API直观且易于学习。

RoboBrowser:集成了Python库的浏览器

RoboBrowser是一个Python库,它集成了RoboForm和RoboCookie,以及lxml和requests库,提供了一个简单的接口来处理HTTP请求和HTML内容。RoboBrowser特别适合于处理需要表单提交和cookies管理的网页。它还支持JavaScript渲染,但需要依赖外部的浏览器驱动程序,如PhantomJS。

选择合适的爬虫框架

选择一个合适的爬虫框架,需要考虑项目的具体需求、开发效率、运行性能以及可维护性等因素。Scrapy是一个功能全面、性能优异的爬虫框架,适合于大型项目和商业应用。BeautifulSoup和PyQuery则更适合于快速开发和简单的数据提取任务。Selenium和Mechanize在处理动态网页方面具有优势,但可能需要更多的资源和时间。RoboBrowser则提供了一个集成的解决方案,方便处理表单和cookies。开发者应根据自己的需求和偏好,选择最合适的爬虫框架。