js获取json数据太长就无法获取了: 深入探讨JavaScript在处理大型JSON数据时的挑战与解决方案

随着Web应用程序的复杂性不断增加,JavaScript在前端应用中处理JSON数据的角色变得愈发重要。当JSON数据量过大时,可能会遇到性能瓶颈和处理限制。本文将就-js获取json数据太长就无法获取了-这一主题展开讨论,分析遇到的常见问题以及提供解决方案。

一、JSON数据的结构与特点

JSON(JavaScript Object Notation)是一种轻量级的数据交换格式,易于人类阅读和编写,同时也方便机器解析和生成。它音符丰富、结构清晰,对前端与后端之间的数据传输尤为重要。

JSON的一项主要缺点是,当数据量较大时,传输和解析所需的时间显著增加。这主要是因为大型数据集需要更多的内存来存储,以及在解析这些数据时JavaScript引擎可能会出现性能下降的问题。

当我们尝试通过JavaScript获取并处理过大的JSON数据时,可能会遇到“数据过大,无法获取”的错误提示,这通常是因为浏览器内存限制导致的。

二、处理大型JSON数据的常见问题

处理大型JSON数据时,开发者可能会面临多种问题,其中最常见的包括以下几点:

1. **内存超限**:当JSON数据过于庞大且未能进行合理的优化和划分时,浏览器可能会因为内存超限而无法成功解析。

2. **网络速度**:JSON数据的下载速度直接影响用户体验。如果数据过大,加载时间过长,用户可能会失去耐心,从而影响使用体验。

3. **解析速度**:在JavaScript中解析大型JSON数据往往需要更多的计算时间,这会导致应用程序的响应时间变慢。

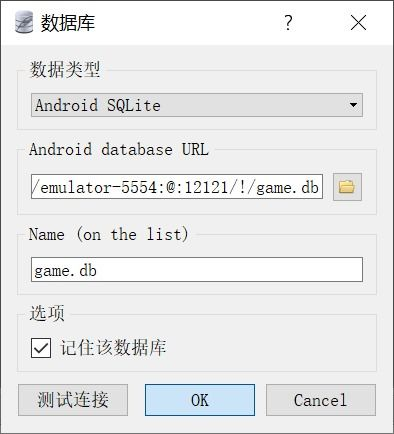

4. **跨域请求**:如果JSON数据来源于不同的域名,浏览器的跨域安全策略可能会导致无法获取数据。

三、解决方案:如何高效处理大型JSON数据

尽管大型JSON数据带来了许多挑战,但依然有多种方法能够有效处理这些问题,保证数据的顺利获取与解析。

1. **数据分页**:将大型JSON数据分割为多个小块进行加载是应对数据过大的有效策略。通过实施服务器端分页或前端动态加载,可以显著减少一次请求的数据量。这不仅提升了性能,也改善了用户体验。

2. **使用流式传输**:流式传输技术允许你在数据完全下载之前即开始处理数据,可以有效减少内存使用。比如,Node.js的Streams模块允许开发者逐块读取数据并进行处理,避免一次性将完整的数据全部载入内存。

3. **压缩数据**:在服务器端使用数据压缩格式(如Gzip)可以有效减少数据传输的大小。通过压缩,用户端的下载时间可以大幅缩短,进而提高用户体验。

4. **JSON Schema**:通过设置JSON Schema可以进行数据的验证与规范化,确保数据的正确性和一致性。这在处理较大数据集时尤为重要,能够帮助开发者更有效地识别和解决数据结构问题。

5. **Web Worker**:如果在浏览器中处理的数据过大,考虑利用Web Worker。Web Worker允许在后台线程中执行JavaScript代码,这样可以避免阻塞主线程,提高应用的响应性。

四、与展望

在现代Web开发中,处理大型JSON数据已成为一个不可避免的挑战。借助以上的解决方案,开发者能够有效地优化数据的传输与处理性能,保证良好的用户体验。

随着技术的不断进步,未来我们期待出现更多高效的库和工具,帮助开发者更便捷地处理大型JSON数据。同时,多线程编程、优化请求、简化数据结构等方式也将持续推动前端开发的发展方向。

处理大型JSON数据的能力不仅关系到应用的性能,也直接影响到用户体验。深入理解和解决这些挑战将帮助我们在竞争激烈的开发环境中保持领先地位。