Python爬虫有哪些:深入探索Python网络数据抓取工具

Python爬虫概述

Python作为一种流行的编程语言,因其简洁的语法和强大的库支持,成为了编写网络爬虫的首选工具。网络爬虫,通常被称为爬虫或spider,是一种自动浏览网页并从中提取信息的程序。Python爬虫利用Python语言的灵活性和各种库,可以高效地获取、解析和存储网页数据。

常用的Python爬虫库

Python社区提供了多种库来支持爬虫的开发,以下是一些常用的库:

- Requests:一个简单易用的HTTP库,用于发送各种HTTP请求。

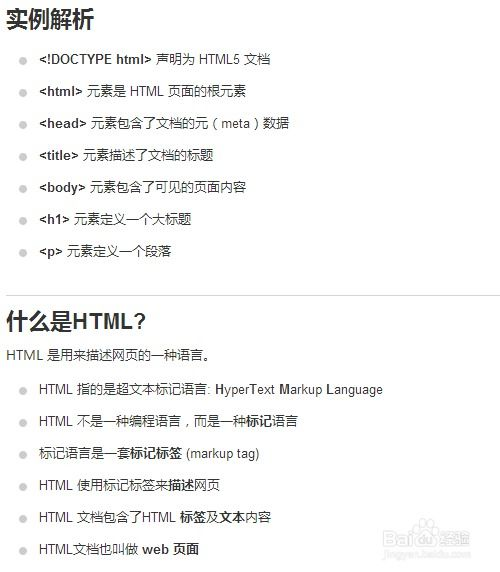

- Beautiful Soup:一个用于解析HTML和XML文档的库,可以从网页中提取数据。

Python爬虫的应用场景

Python爬虫可以应用于多种场景,包括但不限于:

- 数据采集:从网站获取数据,用于市场分析、研究等。

- 信息监控:监控特定网站或社交媒体平台,获取最新信息。

- 自动化测试:使用Selenium等工具进行Web应用的自动化测试。

- 内容聚合:从多个网站抓取内容,聚合到一个平台上。

- 学术研究:收集特定领域的数据,进行深入分析和研究。

Python爬虫的开发步骤

开发一个Python爬虫通常包括以下步骤:

- 确定目标网站:明确需要爬取的网站和数据。

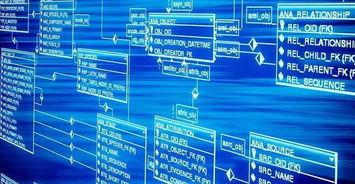

- 分析网页结构:使用浏览器的开发者工具分析网页的HTML结构。

- 编写爬虫代码:使用Python和相关库编写爬虫程序。

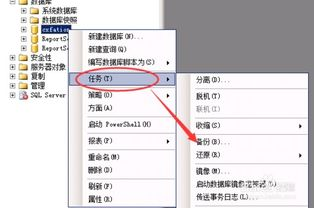

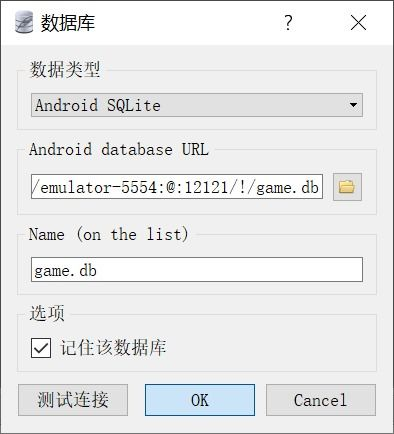

- 存储数据:将爬取的数据存储到数据库或文件中。

- 遵守规则:尊重目标网站的robots.txt文件,合理设置爬取频率,避免给网站服务器带来过大压力。

- 异常处理:编写代码时考虑网络异常、数据格式变化等情况。

Python爬虫的法律和道德问题

在使用Python爬虫时,开发者需要考虑法律和道德问题。以下是一些需要注意的点:

- 版权问题:确保爬取的数据不侵犯版权。

- 隐私问题:不爬取涉及个人隐私的数据。

- 网站压力:合理设置爬取频率,避免对目标网站造成过大压力。

- 数据使用:合理使用爬取的数据,不用于非法或不道德的目的。

Python爬虫的未来趋势

随着互联网技术的发展,Python爬虫也在不断进步。以下是一些未来趋势:

- 智能化:利用机器学习等技术,使爬虫能够更好地理解网页内容。

- 分布式爬虫:通过分布式架构,提高爬虫的爬取效率和稳定性。

- API化:提供API接口,方便其他程序或服务调用爬虫功能。

- 可视化:提供可视化界面,降低爬虫使用的门槛。

Python爬虫作为一种高效的数据获取工具,在多个领域有着广泛的应用。开发者在使用Python爬虫时,需要考虑技术实现、法律道德等多方面因素,以确保爬虫的合理、有效和