mysql数据库去重: 解决数据冗余问题

在数据库管理中,去重是一个至关重要的操作,特别是在使用MySQL数据库时。去重(Deduplication)是指通过某种方法去掉重复数据,确保数据的唯一性和完整性,这对数据分析、性能优化以及存储管理都有显著的影响。

什么是数据去重?

数据去重的定义是检查数据库中是否存在重复的记录,并通过不同的方法移除这些重复项。在MySQL中,这个过程不仅可以通过SQL查询来实现,也涉及到数据设计的良好实践。重复数据可能导致数据分析错误、报告错误或数据不一致,这就是为什么确保数据唯一性的必要性。

为什么需要去重数据库中的数据?

去重在任何数据库的管理中都是必不可少的。它有助于保持数据的准确性和一致性。如果数据库中存在重复的记录,可能会导致多次计算和存储,进而引发数据不准确的问题。去重可以提高数据库的性能。带有重复数据的数据库可能会导致查询速度缓慢,因为系统需要处理大量的冗余信息。去重还能够节省存储空间,降低数据库的整体维护成本。

MySQL中去重的方法

在MySQL中,去重主要通过SQL语言中的“SELECT DISTINCT”命令和“GROUP BY”语句来实现。以下是几种常见的去重方法:

1. **使用SELECT DISTINCT**: 这个命令用于从一个表中选择不同的值。,如果要从人员表中选择不同的城市,可以使用如下查询:

SELECT DISTINCT city FROM persons;2. **使用GROUP BY语句**: 通过GROUP BY,可以根据某一列进行分组,并仅返回每组的一条记录。这对于需要根据多个字段进行复杂去重的情况非常有用。例子如下:

SELECT name, COUNT(*) FROM persons GROUP BY name;3. **使用子查询**: 在复杂情况下,还可以使用子查询找到重复记录。,可以先找出那些出现超过一次的记录,再进行删除:

DELETE FROM persons

WHERE id NOT IN (SELECT MIN(id) FROM persons GROUP BY name);如何处理已有的重复数据

如果数据库中已经存在重复数据,需要进行清理,有以下几种方法可以实现:

1. **查找重复数据**: 使用简单的SELECT查询来查找重复记录。,如果要查找重复名称的记录,可以使用如下查询:

SELECT name, COUNT(*) FROM persons GROUP BY name HAVING COUNT(*) > 1;2. **移除重复记录**: 找出重复后,可以选择删除或合并记录。使用上述提到的DELETE语句,可以有效地移除冗余数据。

3. **定期维护和去重策略**: 建立定期的数据清理计划,有助于确保数据的长期质量。可以使用MySQL的触发器(Triggers)或事件(Events)来监控并自动处理重复数据。

调整数据结构以防止重复数据

除了直接去除重复数据,数据库设计阶段的良好实践同样至关重要。以下是一些防止数据重复的策略:

1. **设置主键和唯一索引**: 在创建表时,保证设定主键(Primary Key)和唯一索引(Unique Index)。这样能确保某一列的数据不能重复,从而从源头上控制数据的唯一性。

CREATE TABLE persons (

id INT AUTO_INCREMENT PRIMARY KEY,

name VARCHAR(100) NOT NULL,

email VARCHAR(100) UNIQUE);2. **数据验证机制**: 在应用层面进行数据输入的校验。确保在插入新记录之前,先查询该数据是否已经存在,从而避免冗余。

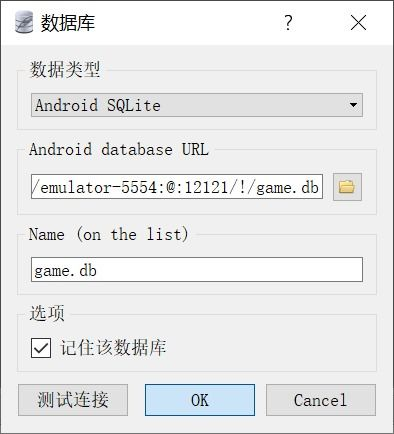

3. **使用外部工具或服务**: 有些外部数据处理工具可以帮助在数据库中进行去重和数据清理,使得这一过程更加高效。

通过对MySQL数据库进行数据去重,可以显著提高数据的准确性、一致性和性能。通过使用合适的SQL查询方法以及预防机制,能够有效管理数据库中的数据冗余问题。在设计数据库结构时,适当地使用主键和唯一索引,并且实践数据验证,可以从根本上防止数据重复的发生。定期的维护和清理操作将帮助保持数据的健康,确保在长时间内能够提供正确且高效的数据分析。