如何获取一个页面所有HTML代码: 了解网页源代码的获取方法

在网络世界中,获取一个网页的所有HTML代码是许多开发者和SEO专家日常工作的重要组成部分。这不仅能够帮助我们理解网页的结构,还能为网站的优化提供数据支持。本文将详细介绍获取网页HTML代码的方法,以及在获取后如何进行分析和利用。

1. 使用浏览器查看源代码

最简单的方法之一是通过现代网页浏览器的内置功能来查看网页源代码。以下是如何进行此操作的步骤:

打开你感兴趣的网页。在页面的任意位置右击鼠标,选择“查看页面源代码”或直接按下快捷键“Ctrl+U”(在Mac上为“Command+Option+U”)。此时,你会看到一个新窗口打开,展示该页面的完整HTML代码。

需要注意的是,源代码可能会包含许多复杂的元素,包括JavaScript和CSS链接,这些内容可能会影响到网页的最终呈现效果。熟悉这些代码的结构,有助于更好地理解该网页是如何运作的。

2. 利用开发者工具分析HTML代码

现代浏览器如Chrome、Firefox和Edge,都提供了强大的开发者工具,能够帮助用户更深入地分析网页内容。获取HTML代码的步骤如下:

在网页上右击并选择“检查”(Inspect),这将打开开发者工具。开发者工具分为多个面板,其中“Elements”面板显示的是该网页的DOM结构。在这里,你可以实时查看和编辑HTML元素,并查看它们对应的CSS样式。

使用“Elements”面板时,你可以展开和收缩各个HTML元素,轻松查看页面中各个部分的结构与属性。如果需要获取特定的HTML元素,只需右击该元素,并选择“复制” > “复制元素”即可将其HTML代码复制到剪贴板中。

3. 利用网页抓取工具获取HTML代码

对于需要频繁获取网页代码的用户,手动操作显然不够高效。这时,可以考虑使用一些网页抓取工具。这类工具通常具有强大的功能,可以自动化获取所需的HTML代码。常用的抓取工具包括:

- Beautiful Soup: 一种Python库,用于从HTML和XML文件中提取数据。它能够将复杂的HTML解析为易于操作的结构。

- Selenium: 主要用于自动化网页测试,但也可以用于抓取动态生成的网页HTML。

- Scrapy: 一个强大的Python网页爬虫框架,适用于大规模数据抓取。

使用这些工具时,需要掌握一定的编程技巧。以Beautiful Soup为例,用户可以编写Python脚本,发送请求获取网页内容,再利用Beautiful Soup解析并提取所需的HTML元素。这样不仅提高了工作效率,还能在需要时轻松分析和处理大量网页数据。

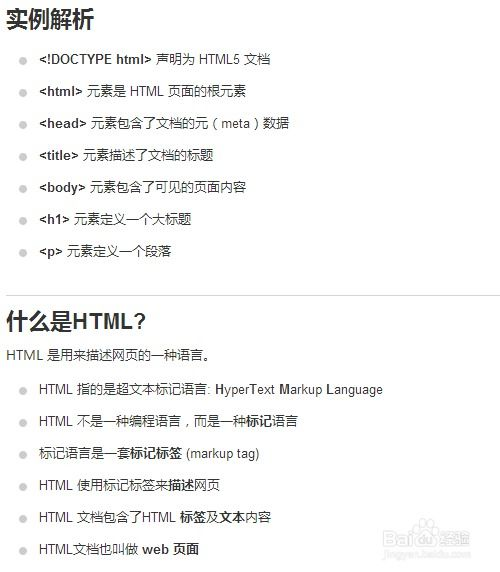

4. 理解HTML代码结构与分析方法

获取网页的HTML代码只是第一步,如何分析和利用这些代码同样重要。HTML结构大致可以分为以下几部分:

- 文档类型声明(Doctype): 指定HTML文档的版本,帮助浏览器正确解析页面。

- 头部(Head): 包含网页的元信息,标题、描述、关键字和链接到CSS文件等。

- 主体(Body): 实际展示在网页上的内容,包括文本、图像、视频等。

理解这些部分后,可以依据网页的需求进行相应的修改和优化。比如,SEO优化通常需要关注网页的标题、元描述和H标签等元素,以提升网页在搜索引擎中的排名。通过分析获取的HTML代码,你可以了解当前页面的SEO效果,并根据需要进行改进。

5. 遵循伦理与法律规定

在获取网页的HTML代码时,遵循伦理与法律规定是非常重要的。许多网站在其使用条款中明文禁止抓取其内容。为了避免潜在的法律风险,请在抓取任何网页之前,务必仔细阅读相关网站的条款与条件。这不仅能保护你的合法权益,也尊重了其他开发者和网站的劳动成果。

如果确实需要抓取某些网页,可以尝试联系网站管理员,寻求获得允许。使用robots.txt文件了解网站的抓取政策也是一个不错的选择。

获取一个网页所有HTML代码的方法多种多样,从手动查看源代码到使用编程工具进行自动化抓取,各有优缺点。掌握获取HTML代码的方法后,我们也要关注如何分析和利用这些数据,以实现SEO优化和网页开发的目标。在进行任何抓取操作时,同时要关注法律和伦理问题,确保良好的网络行为。