spark读取mysql数据库: 在分布式环境中高效读取MySQL数据

spark读取mysql数据库: 在分布式环境中高效读取MySQL数据

在大数据处理的背景下,Apache Spark已经成为一种流行的选择,因其强大的处理能力以及对多种数据源的支持。尤其是当需要从关系型数据库(如MySQL)中提取数据时,Spark显示出了其优越之处。本文将详细介绍如何使用Spark读取MySQL数据库,以及在这一过程中需要注意的一些要点。

什么是Apache Spark?

Apache Spark是一个开源大数据处理框架,提供了高速的内存计算和分布式数据处理能力。它支持多种编程语言如Scala、Java、Python和R,使得数据科学家和工程师可以方便地进行数据分析和机器学习。Spark的核心是一个快速的通用数据处理引擎,能够处理大规模数据集,并能够与其他大数据工具(如Hadoop)集成。

为什么选择Spark读取MySQL?

选择Spark来读取MySQL数据库有多个理由。Spark能够高效地处理大数据集,如果你的MySQL数据量很大,使用Spark可以提高数据读取的速度。Spark的分布式计算特性允许用户在集群环境中并行处理数据,这在传统的单机环境中是不可实现的。Spark的容错机制确保了在节点失效时,数据仍然可以被安全地处理和恢复,这在大规模数据分析中尤为重要。

如何使用Spark读取MySQL数据

要从MySQL数据库中读取数据,用户需要遵循以下步骤:

1. 环境设置

确保你的环境中已经安装了Apache Spark以及MySQL JDBC驱动。你可以通过Maven或者手动下载JDBC jar包,并将其添加到Spark的classpath中。如果是使用Spark的PySpark模块,确保安装了相应的Python库。

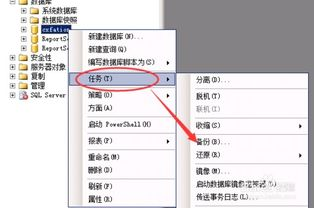

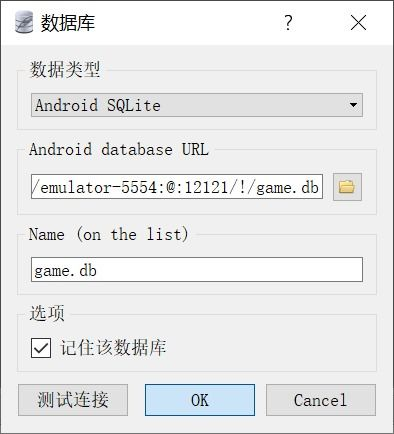

2. 配置数据库连接

在代码中,设置MySQL连接的参数,包括URL、用户、密码等信息。以下是一个示例:

val jdbcUrl = "jdbc:mysql://hostname:port/dbname"

val connectionProperties = new Properties()

connectionProperties.put("user", "yourusername")

connectionProperties.put("password", "yourpassword")

connectionProperties.put("driver", "com.mysql.cj.jdbc.Driver")上面的代码片段演示了如何设置JDBC连接字符串和连接属性。确保替换掉示例中的“hostname”、“port”、“dbname”、“yourusername”和“yourpassword”。

3. 读取数据

使用Spark的DataFrame加载数据,示下:

val df = spark.read.jdbc(jdbcUrl, "your_table_name", connectionProperties)在这个示例中,"your_table_name"是你想要读取的MySQL表名。这样,你就获得了一个包含表数据的Spark DataFrame,随后,利用Spark的各种操作可以对数据进行处理。

4. 数据操作与存储

一旦数据加载完成,你可以使用Spark的API进行数据分析、清洗或转换等操作。比如,你可以调用filter()、select()、groupBy()等方法进行数据处理。以下是一个简单的操作示例:

val result = df.filter($"column_name" > 100).select("column_name", "another_column")完成数据处理后,可以将结果储存回MySQL或的数据源,使用以下代码可以将DataFrame写回MySQL:

result.write.jdbc(jdbcUrl, "your_output_table", connectionProperties)常见问题及注意事项

在使用Spark读取MySQL数据时,有几个常见的问题和注意事项:

1. 数据量大时的性能问题

如果你要读取的数据量非常大,可以考虑使用分区技术。通过在读取时指定分区字段,可以有效地提高读取效率。示例代码如下:

val df = spark.read.jdbc(jdbcUrl, "your_table_name", connectionProperties, columnNameOfHashPartitioning = "id", numPartitions = 10)这将根据id字段把数据分成10个部分并行读取。

2. 数据类型匹配

MySQL和Spark之间的数据类型可能会有不匹配,确保检查数据类型,尤其是在进行数据写入时。某些MySQL数据类型需要特殊的处理,比如BLOB或TEXT字段。

3. 连接效率

在大型应用程序中,频繁地打开和关闭数据库连接会影响性能,因此建议使用连接池或适当的重用连接,以提高效率。

Apache Spark提供了一种高效的方式来读取和分析MySQL数据库中的数据。通过合理配置连接参数,并采用分区等技术,可以在分布式环境中进行快速处理。对于大数据应用,利用Spark的强大特性,结合MySQL的关系型数据存储,可以实现更高效的数据分析和决策支持。

希望本文的介绍能够帮助你在实际项目中更有效地使用Spark读取MySQL数据库,进一步提升数据处理的效率和质量。