如何用HTML代码监控一个整个网页: 了解网页监控的基本方法与实现

如何用HTML代码监控一个整个网页: 了解网页监控的基本方法与实现

在现代互联网时代,网页监控技术广泛应用于各种场景,价格监控、内容变化检测、流量统计等。本文将介绍如何使用HTML代码监控一个整个网页,通过各种方法来实现网络爬虫和数据监控的基本概念,以及如何使用现有工具或编写简单的自定义代码进行网页监控。

什么是网页监控?

网页监控是指对网页内容或性能进行持续跟踪和分析的过程。通过监控,用户可以实时获得网页的变化信息,价格变动、新内容更新以及网页是否在线等。网页监控的应用范围包括电商网站、论坛网站、博客、新闻网站等,帮助用户及时了解信息变动并做出决策。

网页监控的基本工具与技术

在进行网页监控时,通常可以采用以下几种工具或技术:

1. **网络爬虫(Web Crawlers)**:网络爬虫是一种自动访问网页并提取其数据的程序。它可以用来监控网页的变化、抓取特定内容等。常见的网络爬虫库有Python中的Beautiful Soup和Scrapy,能够方便地获取网页数据并处理。

2. **API接口**:许多网站提供API(应用程序编程接口),允许开发者直接访问其数据。通过API获取数据通常比通过HTML代码解析简单、快速且高效。,社交媒体平台和电商网站通常会提供公开的API,用于开发者获取特定数据。

3. **定期检查工具**:有些第三方工具如Visualping和Page Monitor,专门用于监控网页的变化。这些工具通过设置阈值,自动对比网页内容,并在检测到变动时发出通知。

如何用HTML代码进行网页监控

虽然使用现成的工具可以快速实现网页监控的效果,但对于编程爱好者或者需要定制化需求的用户,编写HTML代码进行网页监控的过程也是非常有趣且实用的。下面是一个基本的实现步骤:

1. **选择监控目标**:明确需要监控的网页和特定内容(如价格、文章、图片等)。记下网页的URL,并使用浏览器的检查工具查看需要监控的元素的HTML结构。

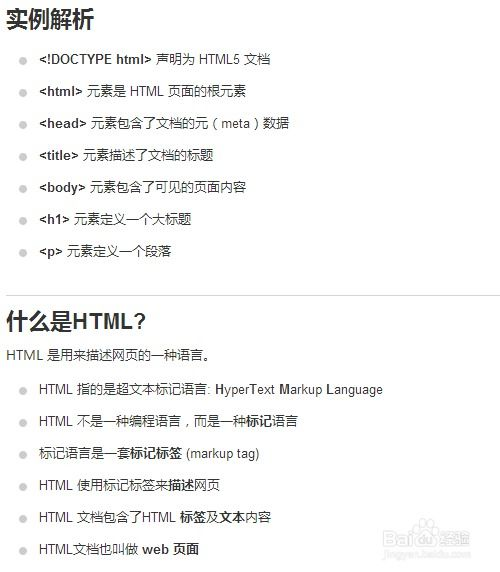

2. **爬虫代码基础**:选择一种编程语言(如Python、JavaScript等)来编写爬虫代码。以下示例展示了如何使用Python和Beautiful Soup进行简单的网页监控:

```python

import requests

from bs4 import BeautifulSoup

URL = "你的目标网页URL" res = requests.get(URL) soup = BeautifulSoup(res.text, 'html.parser')

特定元素 = soup.select("你需要监控的CSS选择器")

print(特定元素)

```

3. **周期性检查**:要定期检查网页变化,可以使用定时任务(如cron作业)来定时运行上述代码。在每次运行中,保存上次的内容,并与当前内容进行比较,以便检测变化。

4. **发出通知**:一旦检测到网页内容变化,可以通过邮件、短信或消息应用(如Slack)等方式通知用户。可以使用SMTP库发送邮件,或者使用相应的API进行消息推送。

需要注意的事项

在进行网页监控时,用户应注意以下几点:

1. **遵守网页的Robots.txt文件**: 大多数网站都有robots.txt文件,定义了允许和禁止爬虫访问的规则。创建爬虫之前,务必检查此文件,遵守网站规定,以避免不必要的法律问题。

2. **合理设定请求间隔**:过于频繁地请求服务器可能会引起服务器的防爬虫机制,导致IP被封禁。建议合理设定请求间隔,一般设定在几分钟到几小时不等。

3. **注意数据隐私**: 在监控用户生成内容或任何敏感数据时,务必遵循数据隐私法,GDPR或CCPA,以保护用户的个人信息。

使用HTML代码监控网页是一项有趣且实用的技能,能够帮助用户及时获取重要信息。无论是使用已有工具,还是自己编写爬虫代码,合理选择合适的方法是关键。随着数据监控技术的不断发展,网页监控的应用场景也将会越来越广泛。希望本文能为您提供清晰的思路和实用的指导,帮助您在网页监控领域取得成功。