网页内容抓取技巧,全面掌握HTML代码爬取方法

选择合适的爬虫工具

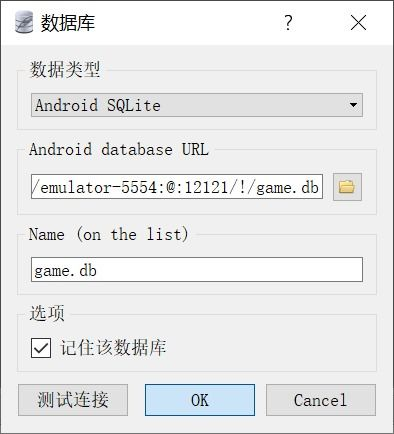

要将HTML代码全部爬下来,需要选择合适的爬虫工具。市面上有许多爬虫工具可供选择,如Python的Scrapy框架、Node.js的Puppeteer和Cheerio库等。这些工具可以帮助您快速、高效地抓取网页内容。在选择工具时,需要考虑其易用性、功能强大程度以及是否支持异步抓取等因素。

编写爬虫程序

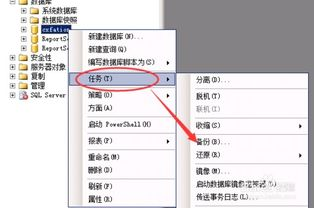

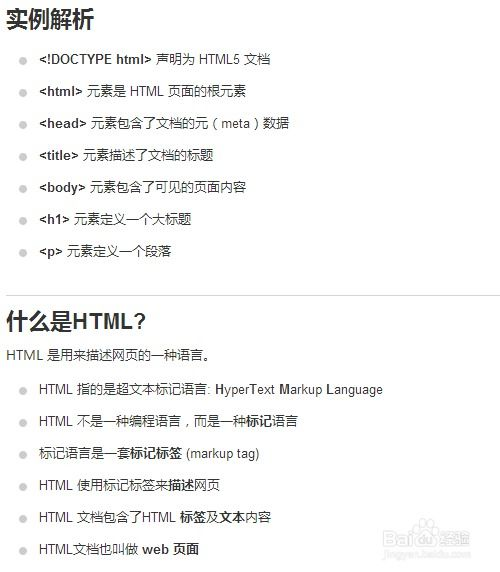

在编写爬虫程序之前,需要对目标网页的结构进行分析。可以使用浏览器的开发者工具查看网页的HTML结构,了解需要抓取的数据在网页中的位置。这一步对于编写高效的爬虫程序至关重要。

根据分析结果,编写相应的抓取代码。以Python的Scrapy框架为例,需要定义一个Spider类,重写其parse方法,并在方法中编写抓取逻辑。对于Node.js的Puppeteer,需要编写一个异步函数,使用Puppeteer提供的API来控制浏览器,抓取所需数据。

处理反爬虫机制

许多网站会设置反爬虫机制来防止数据被爬取。在爬取HTML代码时,需要了解并处理这些反爬虫机制。常见的反爬虫手段包括IP限制、User-Agent检查、验证码等。针对这些反爬虫机制,可以采取更换IP、设置合适的User-Agent、使用验证码识别服务等方法来规避。

本文详细介绍了如何将网页内容完整爬取的方法,包括选择合适的爬虫工具、编写爬虫程序以及处理反爬虫机制。掌握这些技巧,可以帮助您更高效地获取网页上的HTML代码,为后续的数据挖掘和分析工作打下坚实基础。