SQLite数据库大小:优化和控制策略

SQLite数据库大小限制:理解其影响

SQLite数据库的大小限制是一个非常重要的话题,尤其是在开发和部署应用程序时。SQLite的文件大小限制为140 terabytes,这意味着数据库文件可以容纳大量数据。虽然这一限制在绝大多数应用场景下都显得足够大,但仍然需要考虑设备存储和性能的影响。

SQLite的大小限制在特定情况下可能会影响应用程序的性能。如果数据库文件过大,查询的响应时间可能会增加,尤其是在缺乏适当索引的情况下。进行数据备份和恢复操作时,大型数据库可能会耗费更多的时间和资源。开发者需要综合考虑数据库的优化策略。

另一个需要关注的方面是,SQLite的大小限制可能在多用户环境中引起问题。当多个用户同时访问和修改数据库时,文件的锁定机制可能导致性能瓶颈,因此在设计应用时应谨慎处理并发访问。在此情境下,设置合理的数据分区和使用合适的数据库引擎可能会更为有效。

在实际应用中,开发者在考虑SQLite数据库的大小限制时,往往需要根据具体的业务需求评估性能、数据完整性及存储扩展性。因此,了解SQLite的数据库大小限制及相关影响,对于构建高效、可扩展的应用程序至关重要。

SQLite数据库大小优化技巧:提升性能

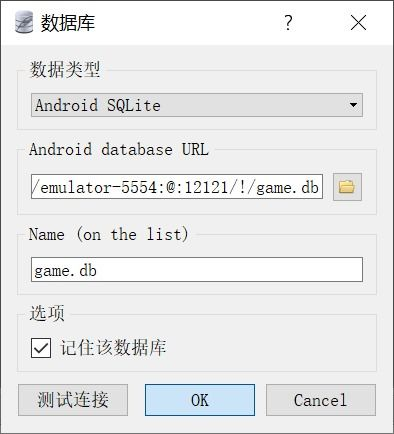

对于SQLite数据库大小优化,可以考虑定期进行数据库分析与优化,通过执行ANALYZE命令来更新统计信息,帮助查询优化器选择最佳执行计划。合理设置缓存大小,增大缓存可以减少磁盘I/O操作,提高读取效率。再者,对于不再需要的数据,及时删除并执行VACUUM命令来回收未使用的空间,这不仅减少了数据库文件的大小,还能优化性能。通过分区表技术管理大型数据集,将数据分散到多个物理存储上,有助于提升查询速度和管理效率。避免不必要的索引创建,过多的索引会增加插入、更新和删除操作的时间成本。